MCP Servers para SEO: Guía de Integraciones con Claude Code [2026]

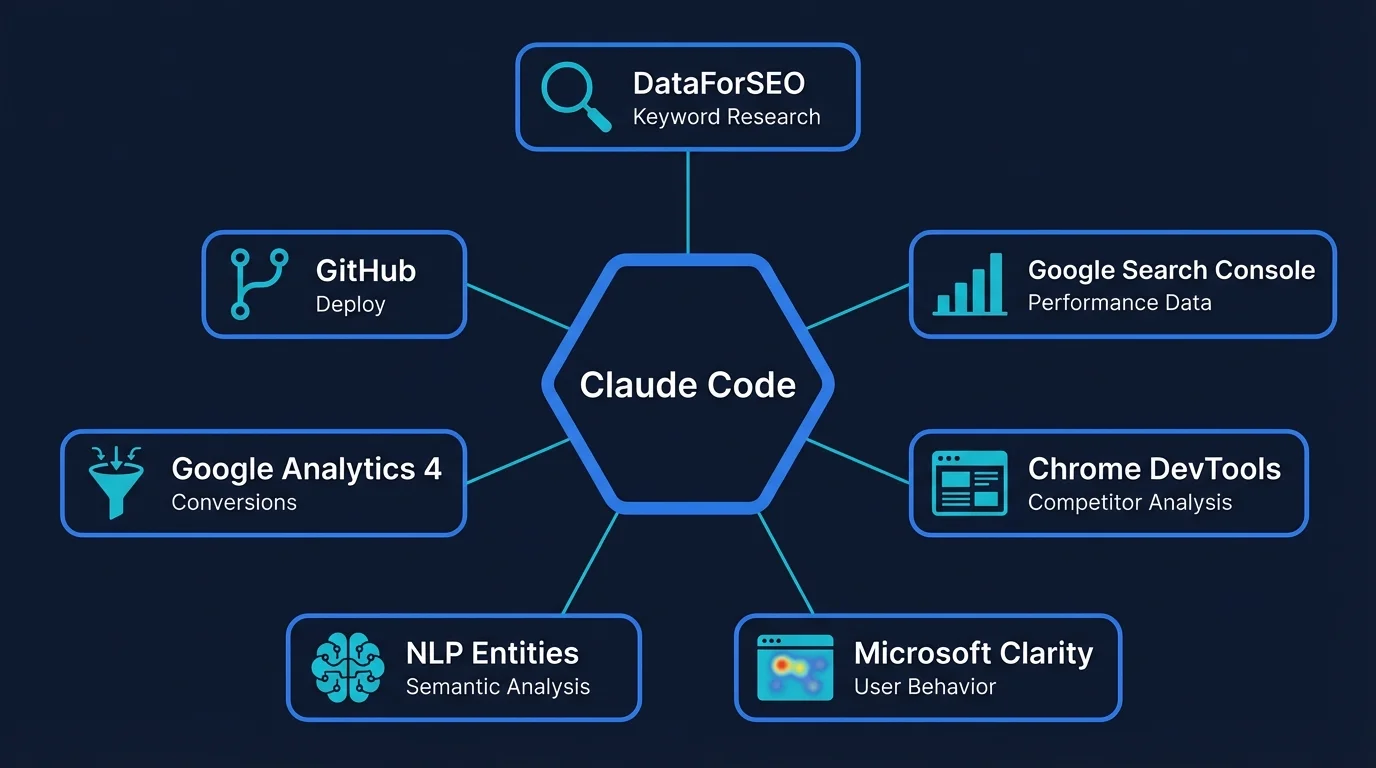

Los mejores MCP Servers para hacer SEO con Claude Code: DataForSEO, Google Search Console, Chrome DevTools, Clarity y más. Configuración real, workflows automatizados y casos de uso prácticos.

Cuando empecé a usar Claude Code para SEO, pensé que el valor estaba en el modelo. En la capacidad de Claude Opus de escribir prompts SEO complejos, de analizar datos y de generar contenido optimizado sin salir de la terminal.

Me equivoqué.

El verdadero poder de Claude Code no está en el modelo que corre atrás. Está en los MCPs — Model Context Protocol servers — que le conectás. Porque un modelo de lenguaje, por bueno que sea, no tiene acceso a datos en tiempo real. No puede consultar Google Search Console, no puede ejecutar keyword research en DataForSEO, no puede inspeccionar las páginas de tus competidores.

Pero con los MCPs correctos, puede hacer todo eso.

Este artículo no es una lista genérica de MCPs disponibles. Es mi stack real de MCP Servers que uso todos los días para hacer posicionamiento orgánico, con configuración concreta, casos de uso y los workflows que armé encima.

¿Qué es un MCP Server (y por qué importa para SEO)?

Un MCP Server es básicamente un puente entre Claude Code y una herramienta externa. Puede ser una API, una base de datos SQL, un navegador en headless mode o cualquier cosa que quieras que la IA pueda controlar.

La analogía simple es esta: Claude Code es un analista inteligente que vive en tu terminal. Los MCPs son los sistemas a los que ese analista puede acceder para traer datos, ejecutar acciones y tomar decisiones informadas.

¿Por qué esto importa para SEO? Porque el trabajo de un consultor SEO es básicamente esto:

- Acceder a datos de distintas fuentes (keyword research, métricas de rendimiento, SERP analysis)

- Cruzar esos datos para encontrar patrones y oportunidades

- Ejecutar acciones basadas en esas decisiones (crear contenido, optimizar páginas, ajustar internal links)

Tradicionalmente hacés esto saltando entre 10 pestañas, copiando y pegando en planillas y tomando notas en Notion. Con MCPs, Claude Code puede hacer las tres cosas en una sola conversación.

MCP es un estándar abierto creado por Anthropic. Ya lo adoptaron Google, OpenAI y otros. Pero Claude Code fue el primero en implementarlo de forma nativa. Y eso es exactamente lo que lo hace tan útil para automatización de auditorías y rastreo e indexación.

Los MCP Servers que uso para hacer SEO (mi stack completo)

Acá va la lista completa de MCPs que tengo conectados a Claude Code. No son todos los que existen — son los que uso todos los días.

| MCP Server | Qué hace | Caso de uso SEO |

|---|---|---|

| DataForSEO | Keyword research, SERP analysis, rankings, tráfico estimado | Research completo antes de escribir contenido, detección de trending nodes, análisis competitivo |

| Google Search Console (SQL) | Métricas GSC vía SQL: clics, impresiones, CTR, posición | Detección de oportunidades, análisis de rendimiento orgánico, identificación de long-tail keywords |

| Chrome DevTools | Control de navegador headless: navegar, capturar snapshots, inspeccionar DOM | Análisis de competidores, verificación de implementaciones técnicas, UX research |

| Microsoft Clarity | Mapas de calor, rage clicks, dead clicks, scroll depth | Detección de problemas UX que afectan SEO, optimización de conversión desde orgánico |

| Entidades NLP | Análisis semántico con Google NLP API | Inventario microsemántico, desambiguación de entidades, arquitectura de información |

| Google Analytics 4 | Conversiones, tráfico, comportamiento de usuario | Medición de impacto de optimizaciones SEO, análisis de intención de búsqueda real |

| GitHub | Gestión de archivos, PRs, commits | Deploy de contenido, versionado del topical map, gestión del proyecto |

Básicamente, si una herramienta tiene API o permite algún tipo de control programático, existe un MCP para conectarla con Claude Code. Y si no existe, podés crearlo.

MCP de DataForSEO: keyword research sin salir de la terminal

Este es el MCP que más uso. DataForSEO tiene APIs para todo lo que necesitás en keyword research: volumen, dificultad, keywords relacionadas, SERP features, rankings de competidores y hasta trending topics.

Las herramientas que tengo configuradas:

| Tool | Qué consulta | Para qué la uso |

|---|---|---|

KeywordSuggestions | Keywords relacionadas y long-tail | Expandir clusters del topical map, descubrir variaciones |

KwsRelacionadas | Co-ocurrencia semántica entre keywords | Armar el inventario microsemántico, detectar entidades relacionadas |

SerpResultados | SERP features, AI Overviews, URLs que rankean, pack local | Analizar qué tipo de contenido premia Google, identificar featured snippets |

RankedKeywordsGeneral | Keywords de cualquier dominio competidor | Content gap analysis, detectar oportunidades no cubiertas |

TopicalAuthority | Score de autoridad temática de un dominio | Benchmark vs competidores, priorizar qué clusters atacar |

TraficoEstimado | Tráfico orgánico estimado de un sitio | Validar oportunidades antes de crear contenido |

Tendencias | Estacionalidad y volumen histórico | Identificar trending nodes, planificar contenido estacional |

¿Cómo se ve en la práctica?

Le digo a Claude Code: “Haceme un keyword research completo para ‘auditoría seo’ en Chile” y ejecuta en paralelo:

KeywordSuggestions→ Me trae 100+ keywords relacionadas: auditoría seo técnica, auditoría seo gratis, auditoría seo precio, herramientas auditoría seoKwsRelacionadas→ Me muestra co-ocurrencias semánticas: análisis SEO, diagnóstico web, revisión técnica, optimización on-pageSerpResultados→ Me analiza la SERP: hay AI Overview, hay pack local en posición 2, los top 3 son guías largas con FAQs, hay featured snippet en posición 0

En 30 segundos tengo el mapa completo de keywords, la intención de búsqueda dominante y qué estructura de contenido debo usar. Sin abrir Semrush, sin copiar y pegar en planillas, sin cambiar de pestaña.

DataForSEO funciona con pay-as-you-go. Una consulta de keyword research cuesta entre $0.002 y $0.02 dependiendo del tipo. Para research programático es mucho más barato que Ahrefs o Semrush, que te cobran mensualidades aunque no lo uses.

Si trabajás con herramientas SEO tradicionales, este MCP es el primero que deberías conectar.

MCP de Google Search Console con SQL: la data real de tu sitio

La interfaz web de Google Search Console es útil para chequeos rápidos. Pero cuando necesitás queries complejas — filtrar por rango de posiciones, cruzar CTR con impresiones, comparar períodos, segmentar brand vs no-brand — te quedás corto.

Acá es donde entra el MCP de SQL. Tengo toda la data de Google Search Console volcada a una base de datos SQL. Claude Code puede consultarla directamente con lenguaje natural, y traduce mi pregunta a una query SQL correcta.

Las herramientas disponibles:

| Tool | Qué consulta | Caso de uso |

|---|---|---|

consulta_47 | Métricas GSC por keyword: clics, impresiones, posición, CTR | Análisis de rendimiento de keywords específicas |

consulta_47_page | Métricas GSC por página sin desglose de keywords | Identificar Quality Nodes, detectar páginas con alto potencial |

consulta_47_share | Share of voice competitivo | Benchmark de tráfico orgánico vs competidores |

Caso de uso concreto

Le pregunto a Claude Code: “¿Qué keywords están ganando impresiones pero tienen CTR menor al 2%?”

Claude Code ejecuta una query SQL que filtra por:

- Impresiones > 100 (hay volumen real)

- CTR < 2% (oportunidad de mejora)

- Posición promedio < 20 (estamos visibles)

Me devuelve una tabla con las keywords exactas donde optimizar title tags y meta descriptions para mejorar el CTR sin mover un dedo en rankings.

¿Por qué SQL y no la API de GSC directo? Porque la API tiene límites de 5,000 filas por consulta y no permite agregaciones complejas. Con SQL puedo cruzar datos de meses, hacer JOINs con tablas de categorías y construir reportes que la interfaz web ni siquiera soporta.

Esto es el Paso 10 de la metodología de Koray — iteración basada en datos reales de rendimiento orgánico, no en estimaciones de herramientas terceras.

MCP de Chrome DevTools: espiar a la competencia desde la terminal

Este MCP es brutal. Chrome DevTools te da control total sobre un navegador en headless mode. Podés navegar a cualquier URL, interactuar con elementos, capturar screenshots, extraer contenido y hasta analizar requests de red.

¿Por qué lo uso para SEO? Para analizar competidores antes de crear contenido.

Las herramientas principales:

| Tool | Qué hace | Caso de uso SEO |

|---|---|---|

navigate_page | Navega a una URL específica | Entrar a los top 3-5 resultados que arrojó SerpResultados |

take_snapshot | Captura el DOM completo de la página | Extraer contenido, estructura de H2s, formato, profundidad de secciones |

take_screenshot | Screenshot visual de la página | Analizar UX, diseño, CTAs |

list_network_requests | Intercepta requests HTTP | Detectar scripts de terceros, velocidad de carga, recursos bloqueantes |

Caso de uso en el pipeline de contenido

Cuando voy a escribir un artículo nuevo, el proceso completo incluye análisis de competidores:

SerpResultados→ Me trae las URLs que rankean en top 5 para la keywordnavigate_page→ Entro a cada una de esas URLstake_snapshot→ Extraigo todo el contenido: H2s, H3s, longitud de secciones, FAQs, internal links- Análisis de patrones → Claude Code cruza los snapshots y me dice: “Los 5 tienen una sección Q&A con mínimo 5 preguntas. 4 de 5 tienen un H2 dedicado a herramientas. Todos superan las 2,500 palabras”

Con esa inteligencia, escribo contenido que no solo está optimizado para la keyword — sino que cumple con el formato que Google ya está premiando en la SERP actual.

También lo uso para verificar implementaciones propias: chequear que los datos estructurados se renderizan bien, que los Core Web Vitals están en verde, que el diseño mobile es correcto. Todo desde la terminal, sin abrir el navegador.

Si querés hacer una auditoría SEO técnica completa, este MCP es imprescindible.

MCP de Clarity, Entidades y Google Analytics

Estos tres MCPs los uso con menos frecuencia que los anteriores, pero en momentos específicos son clave.

Microsoft Clarity

Clarity te da mapas de calor, grabaciones de sesiones, rage clicks (cuando el usuario hace clic desesperadamente en algo que no responde) y dead clicks (clics en elementos no interactivos).

¿Por qué importa para SEO? Porque problemas de UX afectan directamente el tiempo en página, el bounce rate y las señales de satisfacción del usuario que Google sí mide.

Uso el MCP de Clarity para:

- Detectar elementos que los usuarios esperan que sean clickeables pero no lo son

- Identificar secciones donde la gente se queda estancada (scroll depth bajo)

- Ver qué CTAs están funcionando y cuáles nadie toca

Básicamente, me dice dónde está la fricción que impide que el tráfico orgánico convierta.

Entidades NLP

El MCP de análisis de entidades usa la API de Google NLP para extraer entidades de cualquier texto o URL. Me devuelve:

- Qué entidades detecta Google en el contenido

- El nivel de probabilidad de cada una (score > 0.65 es confiable)

- Las relaciones semánticas entre entidades

Esto es fundamental para armar el inventario microsemántico del topical map. Esos términos que desambiguan tu contenido y lo colocan en el contexto técnico correcto.

Por ejemplo, si escribís “rastreo”, Google no sabe si hablás de rastreo e indexación de buscadores o rastreo satelital. Pero si alrededor aparecen “Googlebot”, “sitemap”, “robots.txt”, queda claro el contexto.

Google Analytics 4

El MCP de GA4 me da acceso a métricas de conversión, tráfico, comportamiento y eventos.

Lo uso principalmente para:

- Medir conversiones desde orgánico (leads, ventas, eventos custom)

- Validar si las keywords que traen tráfico también traen conversión

- Detectar páginas con alto tráfico orgánico pero baja conversión (oportunidad de CRO)

No es el MCP que más uso, pero es el que cierra el loop de medición: el keyword research te dice qué atacar, GSC te dice si estás rankeando, y GA4 te dice si ese tráfico sirve para algo.

¿Cómo configurar un MCP Server en Claude Code?

La configuración de MCPs es más simple de lo que parece. Todo se hace en un archivo JSON.

Paso a paso

1. Creá el archivo de configuración

Los MCPs se configuran en .claude/settings.json o en ~/.claude.json (global para todos tus proyectos).

2. Agregá la sección mcpServers

Cada MCP es un objeto dentro de esa sección. Tiene:

- Un nombre identificador

- El comando que ejecuta el servidor

- Los argumentos del comando

3. Ejemplo de configuración real (DataForSEO)

{

"mcpServers": {

"dfs-kwr": {

"command": "node",

"args": ["/ruta/al/servidor/dataforseo-mcp/index.js"],

"env": {

"DATAFORSEO_LOGIN": "tu_login",

"DATAFORSEO_PASSWORD": "tu_password"

}

}

}

}4. Verificá que esté conectado

Ejecutás /mcp en Claude Code y te lista todos los MCPs disponibles con sus herramientas.

MCPs locales vs remotos

- Locales: Corren en tu máquina. Podés tener un script en Python, Node o lo que sea que levante el servidor

- Remotos: Se conectan a una API externa. Necesitás credenciales pero no instalás nada local

La mayoría de mis MCPs son remotos: DataForSEO, GSC, Clarity y GA4. Chrome DevTools corre local porque controla un navegador en mi máquina.

3 workflows SEO que automaticé con MCP Servers

Acá es donde todo se junta. Los MCPs por separado son herramientas. Los workflows son sistemas completos que podés repetir cada vez que necesitás ejecutar un proceso.

Workflow 1: Research completo para un artículo nuevo

Objetivo: Crear un artículo de blog optimizado para una keyword del topical map.

Pasos:

- DataForSEO —

KeywordSuggestions+KwsRelacionadas+SerpResultadosen paralelo → Mapa completo de keywords, co-ocurrencias semánticas, SERP features - Chrome DevTools —

navigate_pagea los top 3-5 resultados →take_snapshotpara extraer estructura de H2s, formato, FAQs, profundidad - Análisis de intención — Claude Code clasifica el search intent (TOFU/MOFU/BOFU) y define el content type ganador

- Escritura con voice cloning — Redacta el artículo con mi voz, respetando internal links obligatorios, microsemántica del inventario y tono de marca

- Build y deploy —

npm run buildgenera el HTML, Vercel lo despliega

Todo el ciclo — desde research hasta publicación — en una sola sesión de terminal de 2-3 horas.

Workflow 2: Auditoría de rendimiento mensual

Objetivo: Detectar oportunidades de optimización basadas en datos reales de GSC.

Pasos:

- GSC SQL — Consulta de keywords con impresiones > 100 y CTR < 2% → Lista de oportunidades de optimización de title/meta

- GSC SQL — Consulta de páginas con clics en descenso mes a mes → Detectar contenido que perdió posiciones

- Clarity — Análisis de rage clicks y dead clicks en páginas Core → Detectar problemas UX que afectan conversión

- GA4 — Conversiones desde orgánico por página → Identificar contenido que trae tráfico pero no convierte

- Reporte con recomendaciones — Claude Code cruza todo y genera un reporte markdown con acciones priorizadas

Este workflow lo corro el primer lunes de cada mes. Antes me tomaba medio día. Ahora son 20 minutos.

Workflow 3: Detección de oportunidades de contenido

Objetivo: Encontrar keywords donde podemos rankear sin mucho esfuerzo.

Pasos:

- GSC SQL — Keywords con impresiones > 50 y posición promedio entre 11-20 → Estamos cerca de primera página

- DataForSEO —

SerpResultadospara cada una de esas keywords → Ver qué tipo de contenido está rankeando - Chrome DevTools — Navegar a las URLs que rankean → Analizar qué tienen en común (longitud, estructura, FAQs)

- Plan de optimización — Claude Code genera un plan: “Agregar sección Q&A con 5 preguntas. Reforzar microsemántica con estos 8 términos. Agregar 2 internal links a páginas Core”

Este workflow descubre oportunidades de contenido existente que con pequeñas optimizaciones puede saltar de posición 15 a primera página.

Errores comunes al usar MCP Servers para SEO

He cometido todos estos errores. Algunos más de una vez.

1. Confiar ciegamente en los datos sin validar

Los MCPs te traen datos de APIs y bases de datos. Pero las APIs tienen bugs, los datos se pueden desincronizar y los modelos de lenguaje a veces allucinan.

Solución: Siempre validar datos críticos manualmente antes de tomar decisiones estratégicas. Si DataForSEO dice que una keyword tiene volumen 1,000 pero GSC muestra 0 impresiones en 6 meses, algo no cuadra.

2. No controlar costos de API

DataForSEO cobra por consulta. Si le pedís a Claude Code que ejecute 500 queries en paralelo sin darte cuenta, la factura puede ser sorpresiva.

Solución: Configurá límites de rate en el MCP. Revisá el billing dashboard cada semana. Usá cache siempre que puedas.

3. Usar MCPs sin un framework claro

Tener acceso a 10 herramientas sin un workflow definido es peor que tener 2 herramientas con un proceso claro.

Solución: Armá tu CLAUDE.md con workflows paso a paso. Define cuándo usar cada MCP y en qué orden. Eso evita que cada tarea sea una improvisación.

4. Pensar que MCP reemplaza la estrategia

El MCP te trae datos. Claude Code los cruza y te sugiere acciones. Pero la decisión estratégica — qué clusters atacar primero, cómo posicionar la estrategia SEO, cómo balancear contenido TOFU vs BOFU — sigue siendo tuya.

Solución: Usá los MCPs para acelerar la ejecución, no para tomar decisiones de negocio. La estrategia sigue siendo humana.

Preguntas frecuentes sobre MCP Servers y SEO

¿Necesito saber programar para usar MCP Servers?

No necesitás ser desarrollador, pero ayuda entender conceptos básicos de APIs y línea de comandos. Si podés instalar paquetes con npm, editar un JSON y correr scripts de Python, podés configurar MCPs.

La mayoría de los MCPs populares ya vienen con instrucciones de setup paso a paso. Seguís el README, pegás tus credenciales en el JSON y listo.

¿Cuánto cuesta usar MCP Servers para SEO?

Depende de qué MCPs uses:

- Claude Code: Necesitás una API key de Anthropic. El modelo Opus cuesta ~$15 por millón de tokens de input, ~$75 por millón de output

- DataForSEO: Pay-as-you-go. Una consulta de keyword research cuesta $0.002-$0.02

- Google Search Console SQL: Si usás BigQuery, tiene capa gratuita de 1TB/mes. Después $5 por TB procesado

- Chrome DevTools MCP: Gratis, corre local

- Clarity: Gratis

- GA4 API: Gratis

En mi caso, entre Claude API y DataForSEO gasto ~$50-100/mes. Es una fracción de lo que costaría Semrush + Ahrefs + tiempo manual.

¿Puedo usar MCP Servers con ChatGPT o Cursor en vez de Claude Code?

MCP es un estándar abierto, pero hasta ahora solo Claude Code lo implementó de forma nativa.

Cursor tiene soporte experimental de MCPs en beta. ChatGPT no lo soporta todavía (aunque podés usar plugins custom, que son conceptualmente parecidos).

Si querés el ecosistema completo de MCPs hoy, Claude Code es la única opción madura.

¿Los MCP Servers funcionan con Semrush o Ahrefs?

Hasta donde sé, ni Semrush ni Ahrefs tienen MCPs oficiales. Pero podés crear uno custom si tenés acceso a su API.

Personalmente uso DataForSEO porque su API es más flexible, más barata para automatización y tiene mejor documentación para developers.

¿Es seguro conectar mis datos de GSC a un MCP?

Depende de cómo lo configures.

Si usás la API de GSC directamente, la conexión es directa entre tu cuenta de Google y el MCP (sin intermediarios). Las credenciales las manejás con service accounts de Google Cloud, que es el método recomendado por Google para acceso programático.

Si usás un MCP de terceros, revisá que el código sea open source y que las credenciales se almacenen local (no se envíen a servidores externos).

En mi caso, el MCP de GSC con SQL lo armé yo y corre en mi infraestructura. Cero riesgo de fuga de datos.

Conclusión

Los MCP Servers son el puente entre la inteligencia de Claude Code y las herramientas que ya usás para hacer SEO. No reemplazan tu criterio estratégico — amplifican tu capacidad de ejecución.

Cuando conectás DataForSEO, GSC, Chrome DevTools y el resto de tu stack a un solo agente en la terminal, el trabajo de keyword research, análisis competitivo, redacción y optimización de contenido deja de ser un proceso manual de copiar y pegar en 10 pestañas.

Pasa a ser un workflow automatizado que podés repetir cada vez que necesitás crear contenido, auditar rendimiento o detectar oportunidades.

Si ya usás Claude Code y todavía no configuraste MCPs, ese es el siguiente paso lógico. Empezá con uno — DataForSEO o GSC — y construí encima.

Y si todavía estás haciendo SEO completamente manual, mirá el artículo completo sobre Claude Code para SEO para ver cómo armar el setup completo.

Si necesitás ayuda para implementar esto en tu proyecto, o querés una auditoría SEO hecha con este stack, estoy del otro lado. Y si querés probar algo rápido, pegá tu URL en el analizador SEO gratuito y mirá qué sale.