Automatización SEO con Python: Guía Práctica con Scripts y Casos Reales [2026]

Aprende a automatizar tareas SEO con Python: scripts para Google Search Console, auditorías técnicas, keyword research y reportes. Guía con ejemplos prácticos y librerías esenciales.

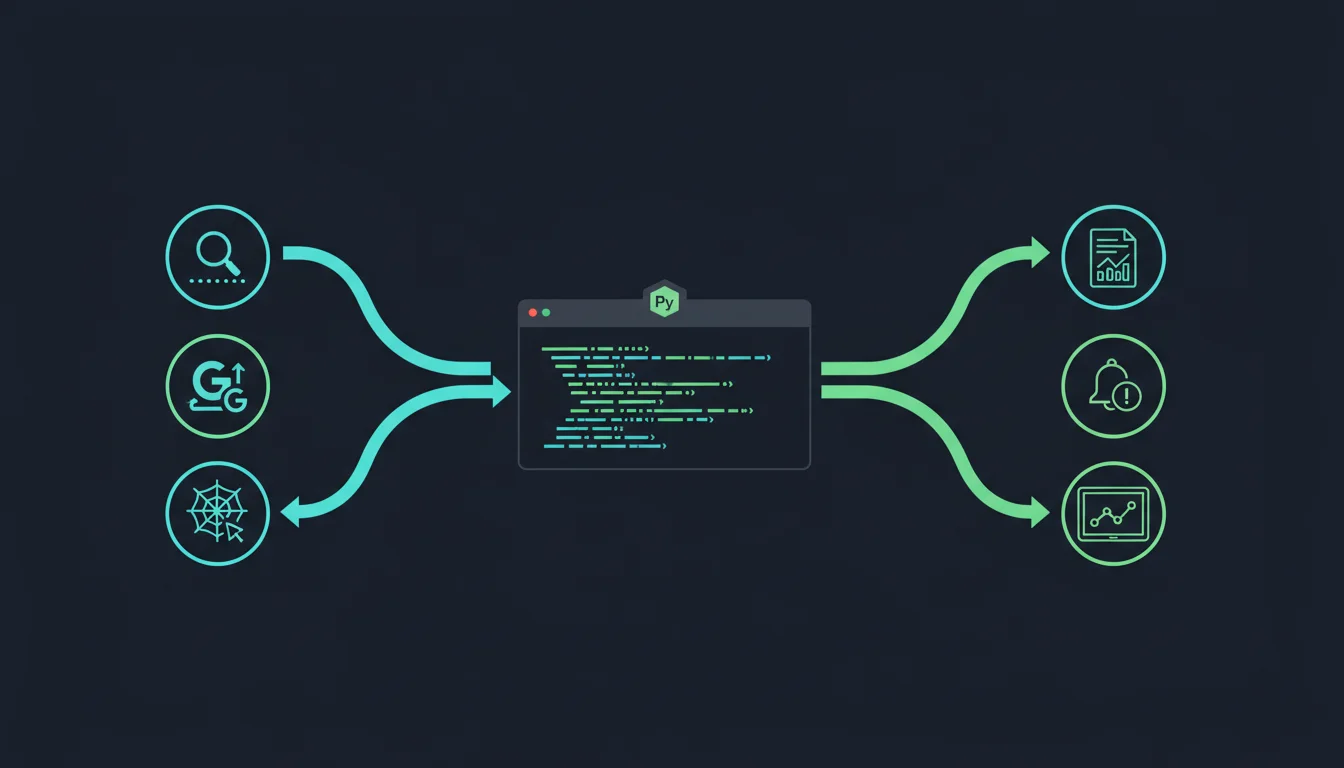

Si trabajás en SEO, hay una realidad que conocés bien: una parte enorme del trabajo es repetitivo. Exportar datos de Google Search Console, cruzar planillas, revisar URLs una por una, armar reportes mensuales. Tareas que consumen horas y que, siendo honestos, no requieren criterio humano para ejecutarse.

Python cambia eso. No porque sea magia, sino porque te permite convertir esas tareas manuales en scripts que corren solos mientras vos te dedicás a lo que realmente importa: analizar datos, tomar decisiones y diseñar la estrategia SEO de tus clientes.

En esta guía te muestro exactamente cómo uso Python para automatizar SEO en mi trabajo diario como consultor. Sin teoría abstracta: scripts concretos, librerías probadas y casos reales.

Por qué Python es el lenguaje ideal para SEO

Hay varios lenguajes de programación que podrías usar. Pero Python tiene tres ventajas que lo hacen perfecto para profesionales de SEO:

Sintaxis legible. No necesitás ser developer senior para escribir un script útil. Python se lee casi como inglés. Si entendés lógica básica, podés automatizar tareas en semanas, no meses.

Ecosistema de librerías masivo. Para cada tarea SEO hay una librería probada: análisis de datos, web scraping, conexión con APIs, visualización. No tenés que reinventar la rueda.

Integración con APIs de Google. Python tiene clientes oficiales para Google Search Console, Google Analytics (GA4), PageSpeed Insights y prácticamente cualquier servicio que uses en tu día a día.

¿Podrías hacer lo mismo con Excel y fórmulas? En parte sí. Pero cuando estás manejando 10,000 URLs, cruzando datos de 5 fuentes distintas y necesitás que eso corra automáticamente cada lunes a las 7am, Excel se queda corto.

Qué tareas SEO podés automatizar con Python

Antes de meternos en el código, aclaremos qué tiene sentido automatizar y qué no.

Lo que sí conviene automatizar

- Extracción de datos: Bajar métricas de Google Search Console, GA4, Semrush, Ahrefs o cualquier API.

- Auditorías técnicas: Verificar status codes, detectar enlaces rotos, validar redirecciones, revisar meta tags en lote.

- Keyword research a escala: Cruzar volúmenes de búsqueda, dificultad y posiciones actuales de miles de keywords.

- Reportes recurrentes: Generar dashboards o reportes en PDF/HTML que se envían solos.

- Monitoreo de cambios: Alertas cuando una URL cambia de posición, pierde tráfico orgánico o aparece un error de indexación.

- Web scraping de la competencia: Extraer estructura de contenido, H2s, datos estructurados y frecuencia de publicación.

Lo que NO conviene automatizar

- Decisiones estratégicas: Python te da datos, pero la interpretación sigue siendo tuya. Qué keywords priorizar, qué contenido crear, cómo distribuir el presupuesto, eso requiere criterio.

- Redacción de contenido de calidad: Podés automatizar briefs, pero el contenido que posiciona necesita expertise real y un enfoque E-E-A-T que ningún script genera solo.

- Link building relacional: Podés automatizar la prospección, pero la construcción de relaciones es humana.

Librerías esenciales de Python para SEO

Estas son las librerías que uso prácticamente en cada proyecto. No necesitás dominarlas todas desde el día uno, pero conocerlas te ahorra semanas de búsqueda.

Análisis y manipulación de datos

| Librería | Para qué la uso | Ejemplo |

|---|---|---|

| pandas | Manipular y analizar datos tabulares | Cruzar datos de GSC con keywords de Semrush |

| numpy | Cálculos numéricos y estadísticos | Calcular promedios ponderados de posición |

Pandas es, sin exagerar, la librería más importante. Si solo vas a aprender una, que sea esta. Básicamente transforma cualquier archivo CSV, JSON o respuesta de API en una tabla que podés filtrar, agrupar y exportar en una línea de código.

Web scraping y crawling

| Librería | Para qué la uso | Ejemplo |

|---|---|---|

| requests | Hacer peticiones HTTP | Verificar status codes en lote |

| BeautifulSoup | Parsear HTML y extraer datos | Extraer meta titles y H1s de competidores |

| Scrapy | Crawling a escala | Crawlear sitios completos de 50K+ URLs |

| Selenium | Renderizar JavaScript | Scrapear sitios SPA donde requests no alcanza |

Conexión con APIs

| Librería | Para qué la uso | Ejemplo |

|---|---|---|

| google-auth + googleapiclient | Conectar con APIs de Google | Extraer datos de Search Console y GA4 |

| python-dotenv | Manejar credenciales de forma segura | Cargar API keys sin hardcodearlas |

Visualización y reportes

| Librería | Para qué la uso | Ejemplo |

|---|---|---|

| matplotlib / seaborn | Gráficos estáticos | Visualizar evolución de posiciones |

| plotly | Gráficos interactivos | Dashboards de rendimiento orgánico |

Scripts prácticos: lo que realmente uso en mi día a día

Acá es donde se pone entretenido. Estos no son ejemplos teóricos: son scripts basados en lo que corro en mis proyectos de consultoría.

1. Extraer datos de Google Search Console con la API

Este es probablemente el script que más uso. En vez de entrar a GSC, exportar manualmente y abrir el CSV en Excel, este script baja toda la data y la deja lista para análisis.

from googleapiclient.discovery import build

from google.oauth2 import service_account

import pandas as pd

# Configuración

SCOPES = ['https://www.googleapis.com/auth/webmasters.readonly']

SERVICE_ACCOUNT_FILE = 'credentials.json'

SITE_URL = 'https://tusitio.com'

# Autenticación

credentials = service_account.Credentials.from_service_account_file(

SERVICE_ACCOUNT_FILE, scopes=SCOPES

)

service = build('searchconsole', 'v1', credentials=credentials)

# Request de datos

request = {

'startDate': '2026-01-01',

'endDate': '2026-01-31',

'dimensions': ['query', 'page'],

'rowLimit': 25000

}

response = service.searchanalytics().query(

siteUrl=SITE_URL, body=request

).execute()

# Convertir a DataFrame

rows = response.get('rows', [])

data = []

for row in rows:

data.append({

'keyword': row['keys'][0],

'pagina': row['keys'][1],

'clics': row['clicks'],

'impresiones': row['impressions'],

'ctr': round(row['ctr'] * 100, 2),

'posicion': round(row['position'], 1)

})

df = pd.DataFrame(data)

df.to_csv('gsc_datos.csv', index=False)

print(f"Exportados {len(df)} registros")¿Qué ganás con esto? En vez de exportar mes a mes desde la interfaz de GSC (que tiene límite de 1,000 filas), bajás hasta 25,000 registros de un tirón, filtrados exactamente como necesitás.

2. Auditoría técnica de URLs en lote

Cuando tenés un sitio con miles de páginas, revisar status codes, redirecciones y meta tags manualmente es inviable. Este script lo hace en minutos.

import requests

from bs4 import BeautifulSoup

import pandas as pd

from concurrent.futures import ThreadPoolExecutor

def auditar_url(url):

try:

response = requests.get(url, timeout=10, allow_redirects=True)

soup = BeautifulSoup(response.text, 'html.parser')

title = soup.find('title')

meta_desc = soup.find('meta', attrs={'name': 'description'})

h1 = soup.find('h1')

canonical = soup.find('link', attrs={'rel': 'canonical'})

return {

'url': url,

'status_code': response.status_code,

'url_final': response.url,

'title': title.text.strip() if title else 'SIN TITLE',

'title_largo': len(title.text.strip()) if title else 0,

'meta_description': meta_desc['content'] if meta_desc else 'SIN META',

'h1': h1.text.strip() if h1 else 'SIN H1',

'canonical': canonical['href'] if canonical else 'SIN CANONICAL',

'redireccion': url != response.url

}

except Exception as e:

return {'url': url, 'status_code': 'ERROR', 'error': str(e)}

# Cargar URLs desde sitemap o CSV

urls = pd.read_csv('urls_sitio.csv')['url'].tolist()

# Crawlear en paralelo (10 hilos)

with ThreadPoolExecutor(max_workers=10) as executor:

resultados = list(executor.map(auditar_url, urls))

df = pd.DataFrame(resultados)

df.to_csv('auditoria_tecnica.csv', index=False)

# Resumen rápido

print(f"URLs analizadas: {len(df)}")

print(f"Errores 4xx/5xx: {len(df[df['status_code'].astype(str).str.startswith(('4','5'))])}")

print(f"Redirecciones: {len(df[df.get('redireccion', False) == True])}")

print(f"Sin H1: {len(df[df['h1'] == 'SIN H1'])}")Esto es básicamente lo que hace Screaming Frog, pero con la flexibilidad de agregar cualquier verificación que necesites: datos estructurados, hreflang, robots meta tags, lo que sea.

3. Detector de canibalización de keywords

Uno de los problemas más comunes en SEO y que pocas herramientas detectan bien de forma automática. Este script cruza datos de GSC para identificar keywords donde múltiples páginas compiten entre sí.

import pandas as pd

# Cargar datos de GSC (del script anterior)

df = pd.read_csv('gsc_datos.csv')

# Agrupar: por cada keyword, cuántas páginas distintas aparecen

canibalizacion = df.groupby('keyword').agg(

paginas_count=('pagina', 'nunique'),

paginas=('pagina', lambda x: ' | '.join(x.unique())),

impresiones_total=('impresiones', 'sum'),

posicion_promedio=('posicion', 'mean')

).reset_index()

# Filtrar: keywords con 2+ páginas compitiendo

canibalizacion = canibalizacion[canibalizacion['paginas_count'] >= 2]

canibalizacion = canibalizacion.sort_values('impresiones_total', ascending=False)

canibalizacion.to_csv('canibalizacion_detectada.csv', index=False)

print(f"Keywords canibalizadas encontradas: {len(canibalizacion)}")Con este análisis podés tomar decisiones concretas: consolidar contenido, aplicar canonical tags, o redirigir páginas duplicadas. Es uno de los quick wins más efectivos en SEO técnico.

4. Monitoreo automatizado de posiciones

En vez de pagar herramientas de rank tracking, podés armar tu propio sistema con la API de GSC y un cron job.

import pandas as pd

from datetime import datetime, timedelta

def obtener_posiciones(service, site_url, keywords, fecha):

"""Obtiene posiciones para un set de keywords en una fecha."""

request = {

'startDate': fecha,

'endDate': fecha,

'dimensions': ['query'],

'dimensionFilterGroups': [{

'filters': [{

'dimension': 'query',

'operator': 'includingRegex',

'expression': '|'.join(keywords)

}]

}],

'rowLimit': 5000

}

response = service.searchanalytics().query(

siteUrl=site_url, body=request

).execute()

return [{

'keyword': row['keys'][0],

'posicion': round(row['position'], 1),

'clics': row['clicks'],

'impresiones': row['impressions'],

'fecha': fecha

} for row in response.get('rows', [])]

# Keywords que querés monitorear

keywords_objetivo = [

'consultor seo chile',

'auditoría seo',

'estrategia seo',

'posicionamiento web chile'

]

# Comparar última semana vs semana anterior

hoy = datetime.now().strftime('%Y-%m-%d')

hace_7_dias = (datetime.now() - timedelta(days=7)).strftime('%Y-%m-%d')

# ... (obtener datos de ambas fechas y comparar)La gracia de esto es que podés programarlo para que corra todos los días y te envíe una alerta solo cuando una keyword clave baje más de 3 posiciones. Nada de revisar dashboards manualmente.

5. Generación automática de reportes

Probablemente el caso de uso que más tiempo me ahorra. En vez de armar reportes en Google Slides o Looker Studio, genero HTMLs con datos frescos.

import pandas as pd

from datetime import datetime

def generar_reporte(datos_gsc, datos_ga4, cliente):

"""Genera un reporte HTML con métricas clave."""

# Métricas principales

clics_total = datos_gsc['clics'].sum()

impresiones_total = datos_gsc['impresiones'].sum()

ctr_promedio = round(datos_gsc['ctr'].mean(), 2)

posicion_promedio = round(datos_gsc['posicion'].mean(), 1)

# Top keywords

top_kw = datos_gsc.nlargest(10, 'clics')

# Construir HTML

html = f"""

<html>

<body>

<h1>Reporte SEO - {cliente}</h1>

<p>Período: {datetime.now().strftime('%B %Y')}</p>

<h2>Resumen de Rendimiento Orgánico</h2>

<ul>

<li>Clics totales: {clics_total:,}</li>

<li>Impresiones: {impresiones_total:,}</li>

<li>CTR promedio: {ctr_promedio}%</li>

<li>Posición media: {posicion_promedio}</li>

</ul>

<h2>Top 10 Keywords por Clics</h2>

{top_kw.to_html(index=False)}

</body>

</html>

"""

with open(f'reporte_{cliente}_{datetime.now().strftime("%Y%m")}.html', 'w') as f:

f.write(html)Este ejemplo es básico, pero la lógica es la misma que uso para reportes completos con gráficos de evolución, comparativas mes a mes y recomendaciones automatizadas basadas en reglas.

APIs que todo SEO debería conocer

Las APIs son la forma de conectar Python con las fuentes de datos reales. Sin APIs, estás limitado a web scraping (que es frágil y puede romperse cuando el sitio cambia).

APIs gratuitas

| API | Qué datos te da | Límite gratuito |

|---|---|---|

| Google Search Console API | Queries, páginas, clics, impresiones, posición, CTR | Sin límite práctico |

| Google Analytics Data API (GA4) | Sesiones, usuarios, conversiones, eventos | 200K requests/día |

| PageSpeed Insights API | Core Web Vitals, métricas de performance | 400 requests/minuto |

| Google NLP API | Análisis de entidades en texto | 5K requests/mes gratis |

APIs de pago (con free tier)

| API | Qué datos te da | Para qué la uso |

|---|---|---|

| DataForSEO | Keywords, SERPs, rankings, backlinks | Keyword research a escala |

| Semrush API | Análisis de competidores, keywords, backlinks | Auditorías competitivas |

| Screaming Frog CLI | Crawl técnico programático | Auditorías técnicas automatizadas |

La combinación de la API de GSC + pandas es el 80% de lo que necesitás para empezar. El resto lo vas agregando según tus necesidades.

Automatización de flujos completos con n8n y cron

Los scripts individuales están bien, pero el verdadero poder está en encadenarlos en flujos que corren solos.

Opción 1: Cron jobs (lo más simple)

Si tu script corre en tu máquina o en un servidor, un cron job lo programa para que se ejecute periódicamente.

# Corre el reporte SEO todos los lunes a las 7am

0 7 * * 1 /usr/bin/python3 /scripts/reporte_semanal.pyOpción 2: n8n (visual y potente)

n8n es una herramienta de automatización open-source que te permite crear flujos visuales. Yo la uso para:

- Flujo de monitoreo: GSC API -> Python (análisis) -> Slack (alerta si hay caída)

- Flujo de reportes: GA4 + GSC -> Python (genera reporte) -> Email al cliente

- Flujo de auditoría: Cron trigger -> Python (crawl) -> Google Sheets (resultados)

La ventaja de n8n sobre cron es que tenés una interfaz visual, manejo de errores, y podés integrar servicios sin escribir código adicional.

Cómo uso Python en mi consultoría SEO

A ver, te lo explico con un caso concreto. Cuando empecé a trabajar con Endado, el primer desafío fue entender un sitio ecommerce con miles de productos y categorías. Hacer eso manualmente habría tomado semanas.

Con Python:

- Crawleé el sitio completo con Scrapy: 15 minutos para mapear estructura, detectar errores técnicos y páginas huérfanas.

- Conecté GSC para cruzar datos de indexación con datos de rastreo: identifiqué páginas indexadas que no recibían tráfico y páginas con tráfico que tenían problemas técnicos.

- Automaticé el reporte mensual: el cliente recibe su informe de rendimiento orgánico sin que yo tenga que armar una presentación.

- Monitoreo continuo: scripts que corren semanalmente y me alertan si hay caídas abruptas en posiciones clave.

El resultado no es solo eficiencia. Es que puedo dedicar mi tiempo a las decisiones estratégicas (qué contenido crear, cómo redistribuir la autoridad interna, dónde enfocar el link building) en vez de estar exportando CSVs.

Por dónde empezar si no sabés programar

Si nunca tocaste Python, la curva de aprendizaje es más corta de lo que pensás. Básicamente necesitás:

Paso 1: Instalar Python

Descargá Python 3.10+ desde python.org. Si estás en Mac, probablemente ya lo tenés instalado.

Paso 2: Aprender lo básico (1-2 semanas)

No necesitás un curso de 6 meses. Con entender variables, listas, loops, funciones y manejo de archivos ya podés hacer cosas útiles. Recursos gratuitos:

- Google Colab: Ejecutá Python en el navegador sin instalar nada. Perfecto para experimentar.

- Documentación de pandas: La guía de “10 minutes to pandas” es todo lo que necesitás para empezar con análisis de datos.

Paso 3: Tu primer script útil

No empieces con algo complejo. Mi recomendación: conectá la API de Google Search Console y exportá tus datos. Es práctico desde el día uno y te motiva a seguir.

Paso 4: Iterar y expandir

Una vez que tu primer script funciona, vas agregando complejidad: filtros más específicos, cruces con otras fuentes de datos, automatización del envío. Cada iteración te enseña algo nuevo.

Lo que Python no reemplaza

Esto es importante y lo digo desde la experiencia: Python es una herramienta, no una estrategia.

Podés tener los scripts más sofisticados del mundo, pero si no sabés interpretar los datos, no te sirven de nada. La automatización elimina el trabajo tedioso para que puedas enfocarte en lo que realmente genera resultados: análisis, decisiones y ejecución.

Un script te dice que tu posicionamiento web cayó 5 posiciones para una keyword clave. Pero decidir si eso se resuelve actualizando el contenido, mejorando los internal links o ganando backlinks, eso sigue siendo trabajo humano.

Por eso siempre digo que la combinación ganadora es: datos automatizados + criterio humano + estrategia basada en resultados de negocio. O sea, lo que yo llamo un enfoque data-driven aplicado al SEO.

Conclusión

Python no es un lujo para SEOs técnicos. Es una ventaja competitiva concreta para cualquier profesional que quiera escalar su trabajo sin escalar sus horas.

Con los scripts y flujos que te mostré en esta guía, podés:

- Reducir horas de trabajo manual en extracción de datos y reportes.

- Detectar problemas técnicos antes de que impacten tu tráfico orgánico.

- Tomar decisiones basadas en datos completos, no en muestras parciales.

- Ofrecer un servicio más profesional y data-driven a tus clientes.

Si estás buscando llevar tu SEO al siguiente nivel con automatización y análisis de datos, hablemos. Es exactamente lo que hago todos los días.